ویژگی ایمنی کودک در iOS 18.2 می تواند محتوای برهنه را محو و به اپل گزارش دهد

در نسخه 18.2 سیستمعامل iOS، اپل قابلیت جدیدی را معرفی میکند که برخی از اهداف پیشین برنامههای اسکن CSAM را دوباره فعال میسازد، این بار بدون نقض رمزنگاری انتها به انتها یا ایجاد درگاههای پشتی برای دولتها.

توسعه ویژگی ایمنی ارتباطات شرکت، که برای اولین بار در استرالیا عرضه میشود، از یادگیری ماشینی محلی برای شناسایی و مات کردن محتوای برهنه استفاده میکند، هشدارهایی را اضافه میکند و قبل از ادامه دادن توسط کاربران، تأییدیهای را طلب میکند. اگر کاربر زیر 13 سال باشد، بدون وارد کردن رمز عبور Screen Time دستگاه، امکان ادامه نخواهد داشت.

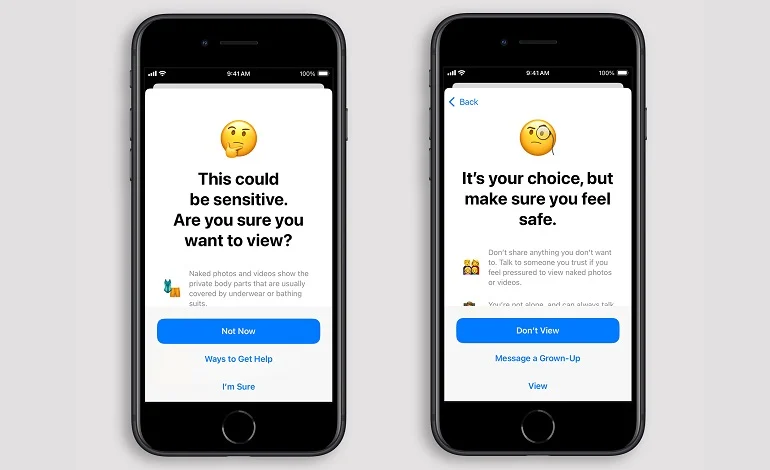

در صورتی که یادگیری ماشینی دستگاه محتوای برهنهای را تشخیص دهد، این قابلیت به صورت خودکار تصویر یا ویدیو را مات میکند، هشداری در مورد حساسیت محتوا نمایش میدهد و راههایی برای کمک گرفتن پیشنهاد میدهد. گزینهها شامل ترک گفتگو یا گروه، مسدود کردن فرد و دسترسی به منابع امنیت آنلاین میباشد.

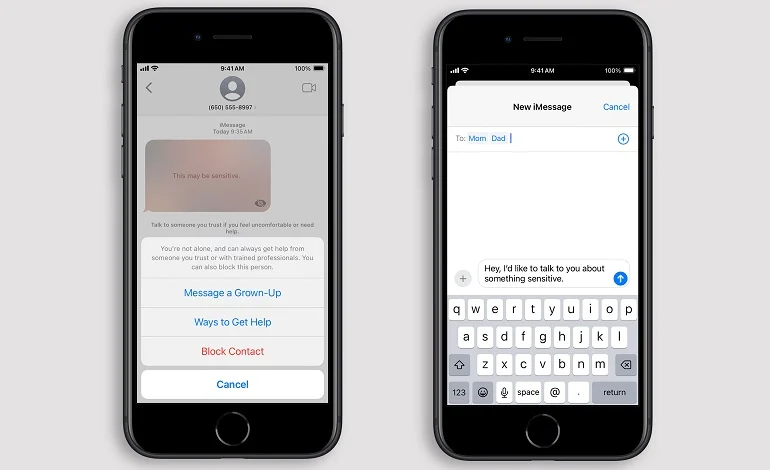

این ویژگی همچنین پیامی را به کودک نمایش داده که تأکید میکند اشکالی ندارد اگر محتوا را نبیند یا چت را ترک کند. علاوه بر این، گزینهای برای ارسال پیام به والدین یا سرپرستان نیز وجود دارد. اگر کودکی 13 ساله یا بزرگتر باشد، میتواند تأیید کند که مایل است پس از دریافت هشدارها، به فعالیت خود ادامه دهد – با یادآوریهای مکرر که انصراف دادن مشکلی ایجاد نمیکند و کمک بیشتری در دسترس است.

بر اساس گزارش گاردین، این گزینه شامل امکان گزارش دادن تصاویر و ویدیوها به اپل نیز میشود. این ویژگی، عکسها و ویدیوهای آیفون و آیپد را در پیامها، AirDrop، تصاویر تماس (در برنامه تلفن یا مخاطبین) و تماسهای ویدیویی FaceTime تحلیل میکند. همچنین، اگر کودکی عکس یا ویدیویی را برای به اشتراکگذاری انتخاب کند، این ویژگی “برخی از برنامههای شخص ثالث” را نیز اسکن مینماید.

برنامههای پشتیبانیشده در دستگاههای مختلف تا حدودی متفاوت هستند. در مک، اگر کاربران محتوایی را برای به اشتراکگذاری انتخاب کنند، پیامها و برخی از برنامههای شخص ثالث اسکن میشوند. در اپل واچ، پیامها، پوسترهای تماس و پیامهای ویدیویی FaceTime پوشش داده میشوند. در Vision Pro، این ویژگی پیامها، AirDrop و برخی از برنامههای شخص ثالث را در شرایطی که پیشتر ذکر شد، اسکن میکند.

این ویژگی نیازمند iOS 18، iPadOS 18، macOS Sequoia یا visionOS 2 است. گاردین گزارش داده است که اپل در نظر دارد پس از آزمایشهای انجامشده در استرالیا، این ویژگی را به صورت جهانی گسترش دهد. این شرکت احتمالاً استرالیا را به دلیل وضع قوانین جدیدی که شرکتهای فناوری بزرگ را به نظارت بر محتوای تروریستی و سوءاستفاده از کودکان ملزم میکند، انتخاب کرده است.

در راستای قوانین جدید، استرالیا توافق کرده است که این الزامات فقط “در صورت امکان فنی”اجرا شوند و الزام به شکستن رمزنگاری انتها به انتها و به خطر انداختن امنیت حذف شده است. شرکتها موظفند تا پایان سال به این قوانین عمل کنند.